摘要:本文初步探讨了人工智能领域,重点关注了Transformer和BERT模型的探索与挑战。通过对这些模型的初步了解,我们发现它们在自然语言处理任务中表现出强大的性能。这些模型也面临着一些挑战,如计算资源需求高、训练难度大以及可解释性不强等问题。本文旨在为初学者提供一个入门指南,并激发对人工智能领域更深入研究的兴趣。

本文目录导读:

在人工智能日益发展的今天,作为一个对人工智能几乎毫无了解的人,我面临着接触并理解前沿技术的挑战,导师推荐的关于Transformer和BERT的两篇论文,为我打开了一个全新的领域,但同时也带来了极大的困惑,本文旨在记录我对这两篇论文的初步理解及所面临的困惑。

对人工智能的初步认识

在接触这两篇论文之前,我对人工智能的了解仅限于一些常见的术语和概念,我知道人工智能是一个广泛的领域,涵盖了机器学习、深度学习、自然语言处理等众多子领域,这些概念背后的原理和技术,我几乎是知之甚少。

三、对Transformer和BERT的初步理解

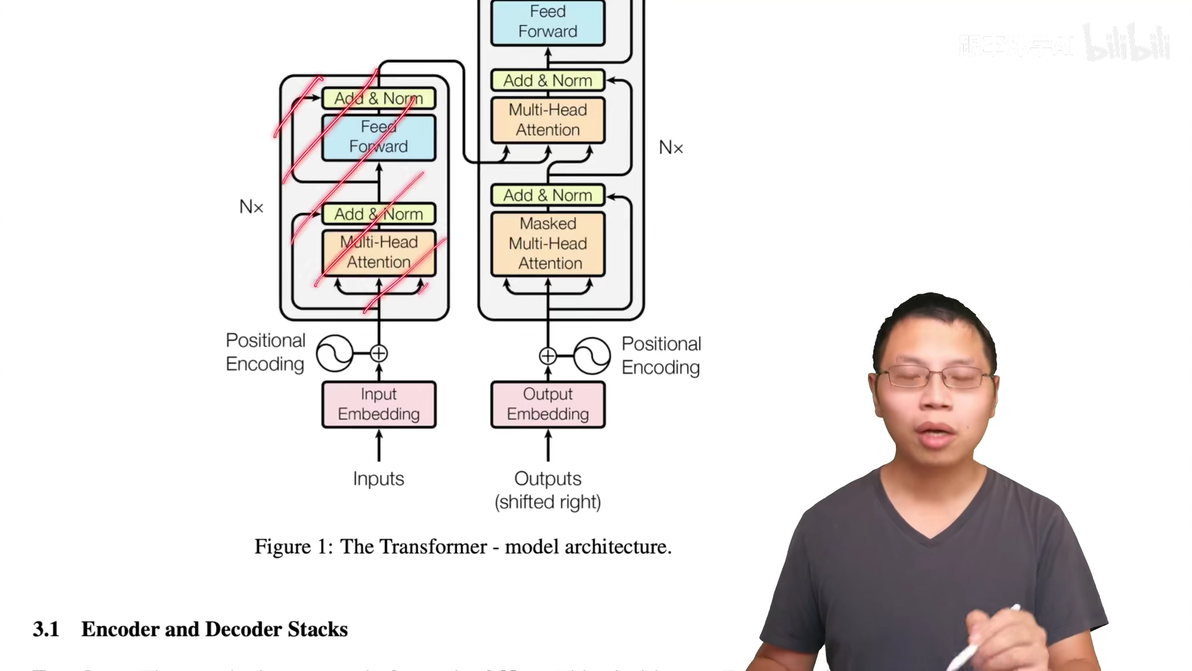

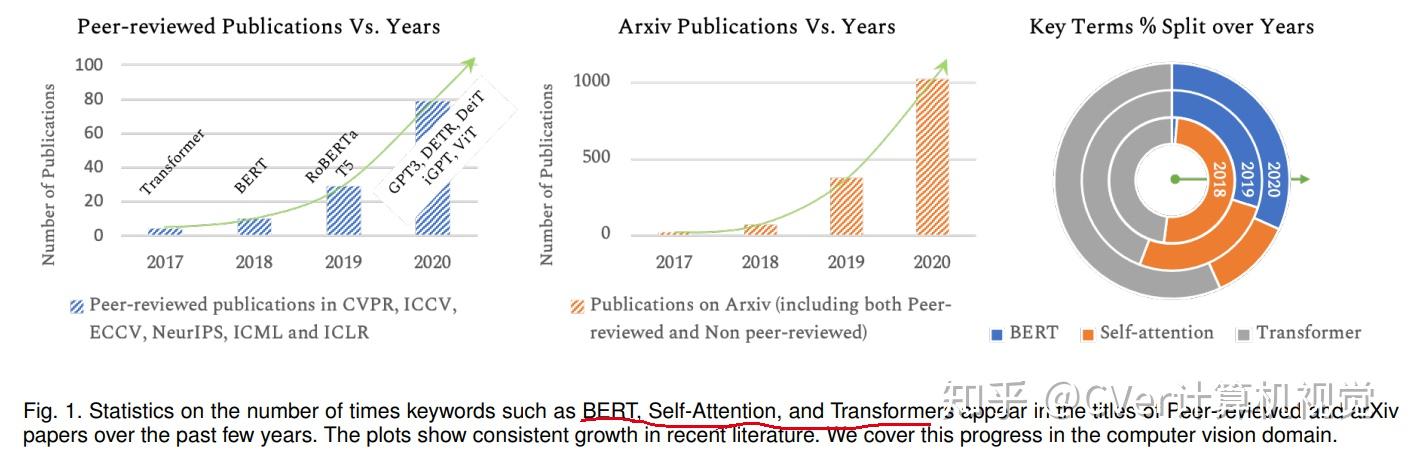

1、Transformer模型:最初,我被“Transformer”这个名词所迷惑,不清楚它究竟是什么,在阅读论文后,我了解到Transformer是一种基于注意力机制的神经网络模型,主要用于处理序列数据,如文本、语音等,其核心是自注意力机制,使得模型在处理序列数据时能够关注到序列内部的依赖关系。

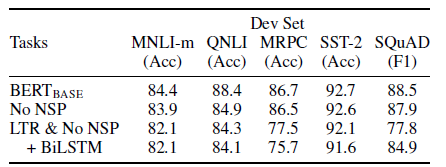

2、BERT模型:BERT(Bidirectional Encoder Representations from Transformers)是基于Transformer模型的预训练模型,它的特点是采用了双向编码,能够在预训练阶段学习到大量的语言知识,在下游任务中,只需要对BERT模型进行微调,就能获得较好的效果。

阅读论文的挑战

1、理论深度:在阅读这两篇论文时,我发现其中涉及的理论知识非常深入,包括神经网络、注意力机制等,对于缺乏基础知识的读者来说,理解起来非常困难。

2、技术细节:论文中涉及的技术细节非常多,如Transformer模型中的自注意力机制、位置编码等,需要读者具备一定的技术背景。

3、术语繁多:在阅读过程中,我遇到了大量的专业术语,如embedding、tokenizer等,这些术语的理解对于理解论文至关重要,但也增加了阅读难度。

困惑与解决方案

1、困惑:在阅读论文过程中,我遇到了许多难以理解的理论和技术细节,由于缺乏基础知识,我很难将这些理论与实际结合起来,形成直观的理解。

2、解决方案:为了解决这个问题,我计划从基础开始,学习相关的理论知识和技术细节,我会尝试寻找一些相关的教程和案例,帮助我更直观地理解这些理论和技术。

3、寻求帮助:我也会向导师和同学请教,寻求他们的帮助和指导,通过他们的解释和指导,我相信我能更好地理解这些论文。

展望未来

尽管我现在对人工智能、Transformer和BERT的了解还很浅薄,但我相信通过不断学习和实践,我会逐渐掌握这些知识和技能,人工智能是一个充满挑战和机遇的领域,我希望能够在这个领域不断探索和学习,为人工智能的发展贡献自己的力量。

作为一个对人工智能毫无了解的人,接触和理解Transformer和BERT这两篇论文对我来说是一个巨大的挑战,这个过程中也让我感受到了学习的乐趣和收获,我相信,只要我保持学习的热情,不断克服困难,我一定能在这个领域取得进步。

京ICP备11000001号

京ICP备11000001号